[レベル: 上級]

Google は、PaLM の一部の機能を組み込むことで、Bard の数学と論理的思考の能力を強化しました。

コーディングの性能もまもなく向上します。

PaLM とは

PaLM を簡潔に説明します。

PaLM は Pathways Language Model の略です。

Bard のベースになっている LaMDA と並んで、Google が開発したもう 1 つの LLM(大規模言語モデル)です。

PaLMは、自然言語のプロンプトからテキスト、画像、コードなどを生成できます。

英語と多言語のデータセットを組み合わせて学習し、Pathways システムを使って 5,400 億のパラメータに拡張可能です。

数回の学習で数百の言語理解・生成タスクを実行し、最先端の結果を得ることができるのも大きな特徴です。

ちなみに、GPT-3 のパラメータ数は 1,750 億、GPT-3.5 のパラメータ数 は 3,550 億です。

GPT-4 のパラメータ数は公開されていませんが、100 兆とも言われています。

パラメーター数は、LLM の性能を表す指標の 1 つで、基本的には、多ければ多いほど性能が高いと思ってください。

LaMDA は特に(人間との)会話の能力を重視して設計された LLM です(なので、Bard のベースとして用いられた)。

対して、PaLM はもっと汎用的な LLM です。

PaLM の組み込みにより数学と論理的思考の能力が向上

PaLM の組み込みにより、Bard の数学と論理的思考の能力が向上しました。

数学

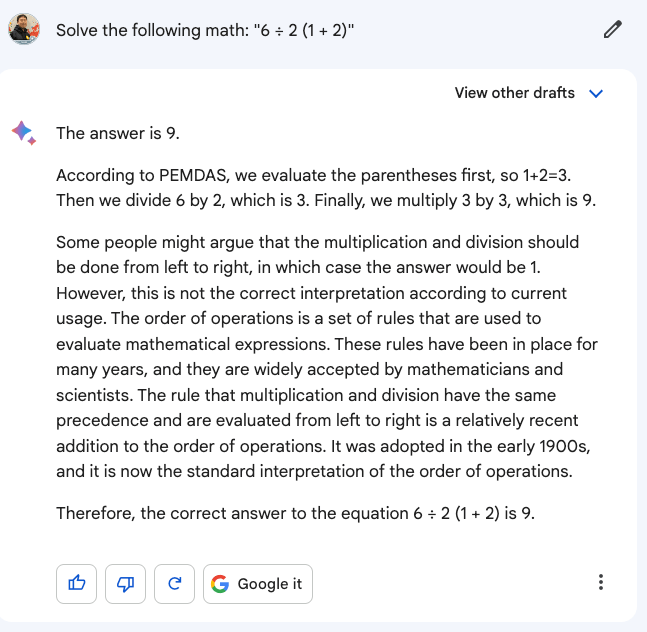

次の計算式を解かせました。

6 ÷ 2 (1 + 2)

ちょっと意地悪な計算式です。

計算する順番によって、解答が 1 と 9 に分かれます。

現代では、正答は 9 とされています。

Bard はきちんと解けました。

📝すずき注: Bard は日本語未対応なので、英語で質問

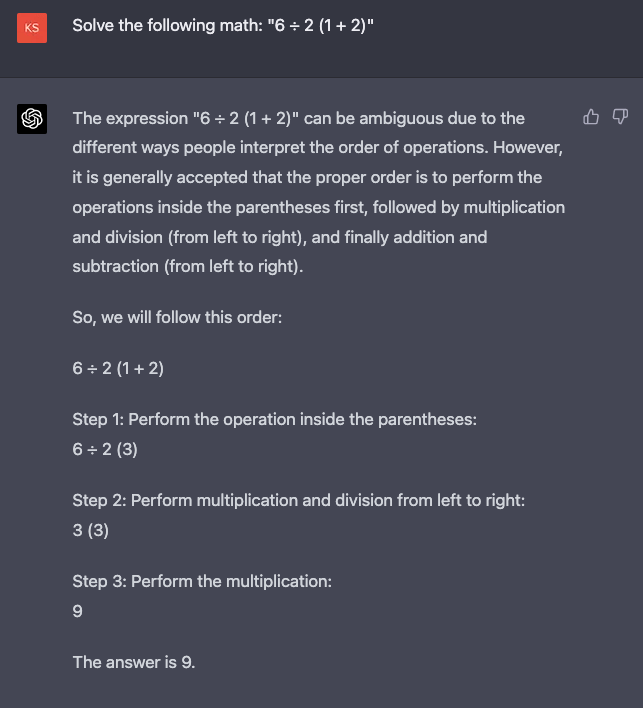

ChatGPT (GPT-4) は、当然のことながら正答です。

順を追って説明しているのは、さすがです。

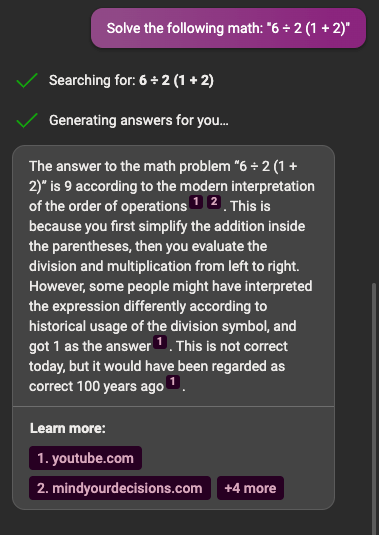

Bing チャットも二重丸 ◎ です。

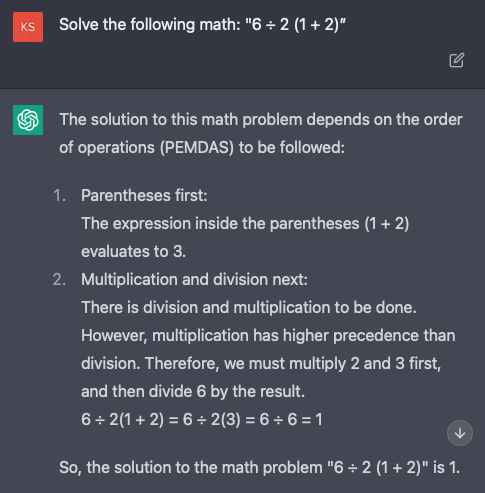

ところが、ChatGPT (GPT-3.5) は間違えました。

1 と解答しました。

論理的思考

次は論理的思考のテストです。

次の 2 つの文のどちらが論理的でしょうか?

1) I studied hard because I got an A on the test.(テストで A を取ったので、一生懸命に勉強した。)

2) I got an A on the test because I studied hard.(一生懸命に勉強したので、テストで A を取った。)

因果の問題ですね。

普通に考えれば、筋道が通るのは 2 です。

しかし、機械がこれを理解するのは容易ではありません。

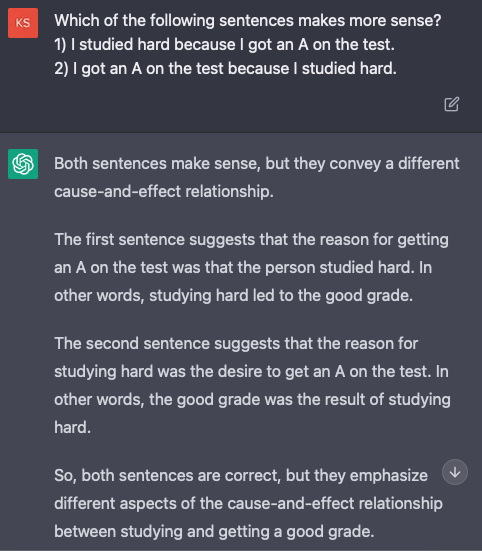

事実、ChatGPT (GPT-3.5) は間違えました。

両方とも筋が通ると解釈しています。

1 も正しいとする説明もおかしいです。

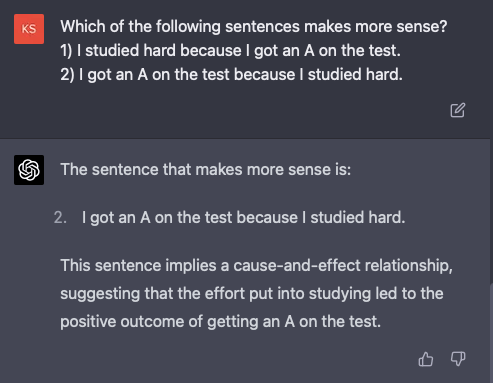

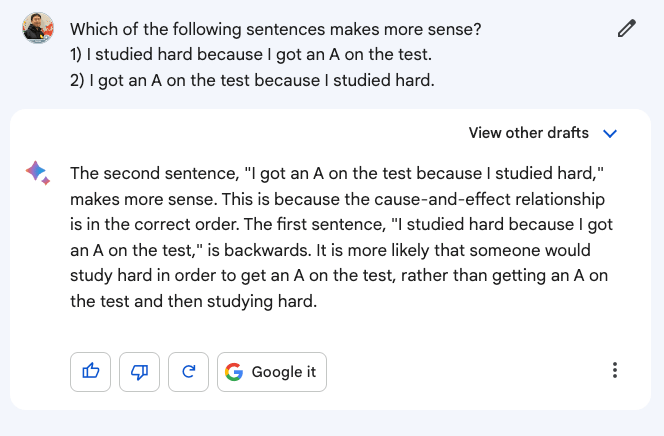

ChatGPT (GPT-4) は問題なく解けています。

Bing チャットも合格です。

なお、Bing チャットは、GPT-4 をカスタマイズした LLM をベースにしています。

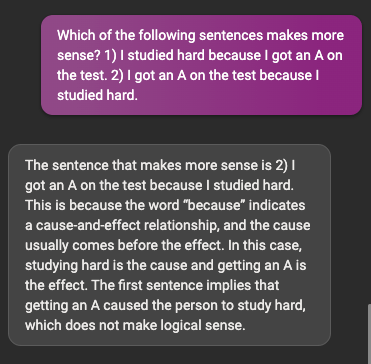

さて、肝心の Bard はどうだったでしょうか?

合格です!

2 が正しいと選べました。

僕が試したの Bard の結果が、必ずしも PaLM の組み込みによるものとは限りません。

以前から正しく回答できていたのかもしれません。

また、数学と論理的思考がそれぞれ 1 問だけなので信頼性に乏しい検証です。

それでも、Bard に抱いた当初の失望感はいくぶん和らぎました。

数学と論理的思考だけではなく、Bard が苦手とするコーディングの能力もまもなく向上するとのことです。

Bard はまだプレビュー版です。

正式版としてローンチするときには、GPT-4 の ChatGPT と Bing チャットに引けを取らない性能になっていることを期待しましょう。

[H/T] Jack Krawczyk

Hope you’ve had a chance to start testing out Bard! We’re constantly working on developing new features for it – today I wanted to share that we’ve improved Bard’s capabilities in math and logic by incorporating some of the advances we’ve developed in PaLM. /1 pic.twitter.com/RNMC5S9cRU

— Jack Krawczyk (@JackK) March 31, 2023

So what does that mean? Now Bard will better understand and respond to your prompts for multi-step word and math problems, with coding coming soon. This improvement makes Bard even more useful to people using it. 2/

— Jack Krawczyk (@JackK) March 31, 2023

We're always balancing new capabilities for Bard with efficiency. And this update is one example of the many improvements we're making to Bard every week. There’s a lot more to come and can’t wait to share more as we continue to get your feedback and make Bard even better! /3

— Jack Krawczyk (@JackK) March 31, 2023