[レベル: 上級]

Googlebot がページをクロールするときにかかるダウンロード時間が 1,000 ミリ秒を超えると、クロールに支障をきたすかもしれません。

一応の目安として、100 〜 500 ミリ秒以内を考慮しておくとよさそうです。

ページのダウンロード時間は 100 〜 500 ミリ秒が理想、1,000 ミリ秒は遅すぎ

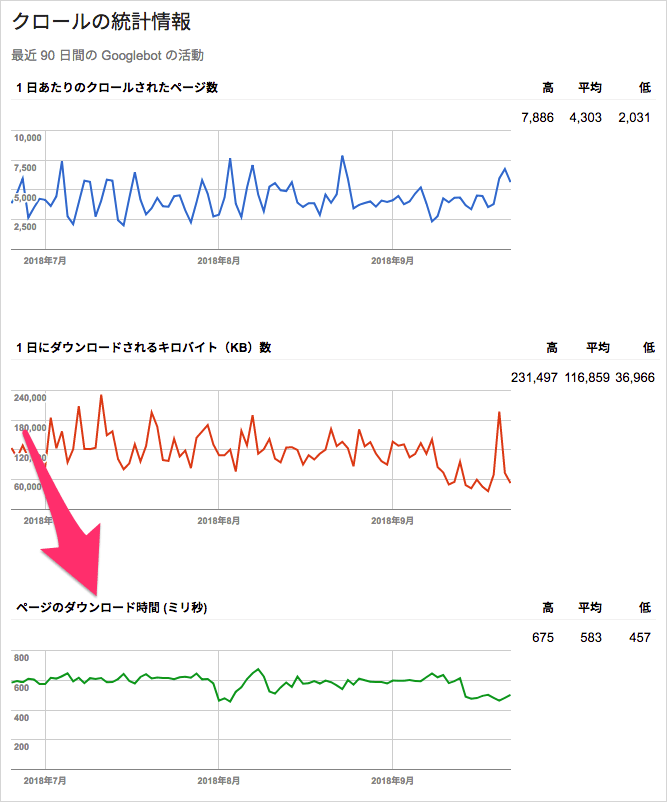

(旧)Search Console のクロールの統計情報レポートでは、ページのダウンロード時間の情報を確認することができます。

ページのダウンロード時間は、Googlebot がリソースを純粋にリクエストするのにかかった時間を示すデータです。

PageSpeed Insights のようにユーザーが使うブラウザの表示にかかる時間ではありません。

リソースは、HTML のほか画像や CSS、JavaScript、PDF なども含みます。

ダウンロード時間の目安に関して、決まった数字を指針として提示するのは難しいと前置きしながらも Google の John Mueller(ジョン・ミューラー)氏は次のようにコメントしました。

一般的に言って、ダウンロード時間が 100 〜 500 ミリ秒くらいであれば (Googlebot は)クロールしやすい。1,000ミリ秒、つまり 1 秒を超えると、サーバーが本当に遅いという兆候になりクロールに制限をかけるかもしれない。

大規模サイトはサーバー速度にも気を配る

数百ページ程度の小規模サイトであれば、サーバーの応答速度はそれほど敏感にならなくても最終的にはクロールされるでしょう。

しかし数十万ページ、数百万ページあるような大規模サイトでは、サーバーが遅いことが原因で Googlebot がクロールに制限をかけてしまうと、必要なページがクロールされなくなってしまうことがありそうです。

ミューラー氏のアドバイスに従って、クロールの統計情報で 100 〜 500 ミリ秒以内を一応の目安として捉えておくといいのではないでしょうか。

ところで、正式版に昇格した新しい Search Console にはクロールの統計情報は移植されていません。

このレポートに相当する機能もありません。

それどころか、同等の機能が新 Search Console で使えるかどうかも不明です。

特に一般的なウェブサイトでは、頻繁にチェックするレポートでもないように思うので、ひょっとしたら新 Search Console ではなくなるかもしれないと個人的には疑っています。