[レベル: 上級]

クロールの統計情報レポートについて解説するヘルプ記事を Google は更新しました。

Googlebot がサイトをクロールする際に robots.txt ファイルをリクエストして使用する仕組みの説明がより詳細になりました。

最後のレスポンスが不成功か、24 時間以上経過している場合の挙動

Google がサイトをクロールする際に robots.txt ファイルをリクエストして使用する仕組みを解説するセクションの更新前です。

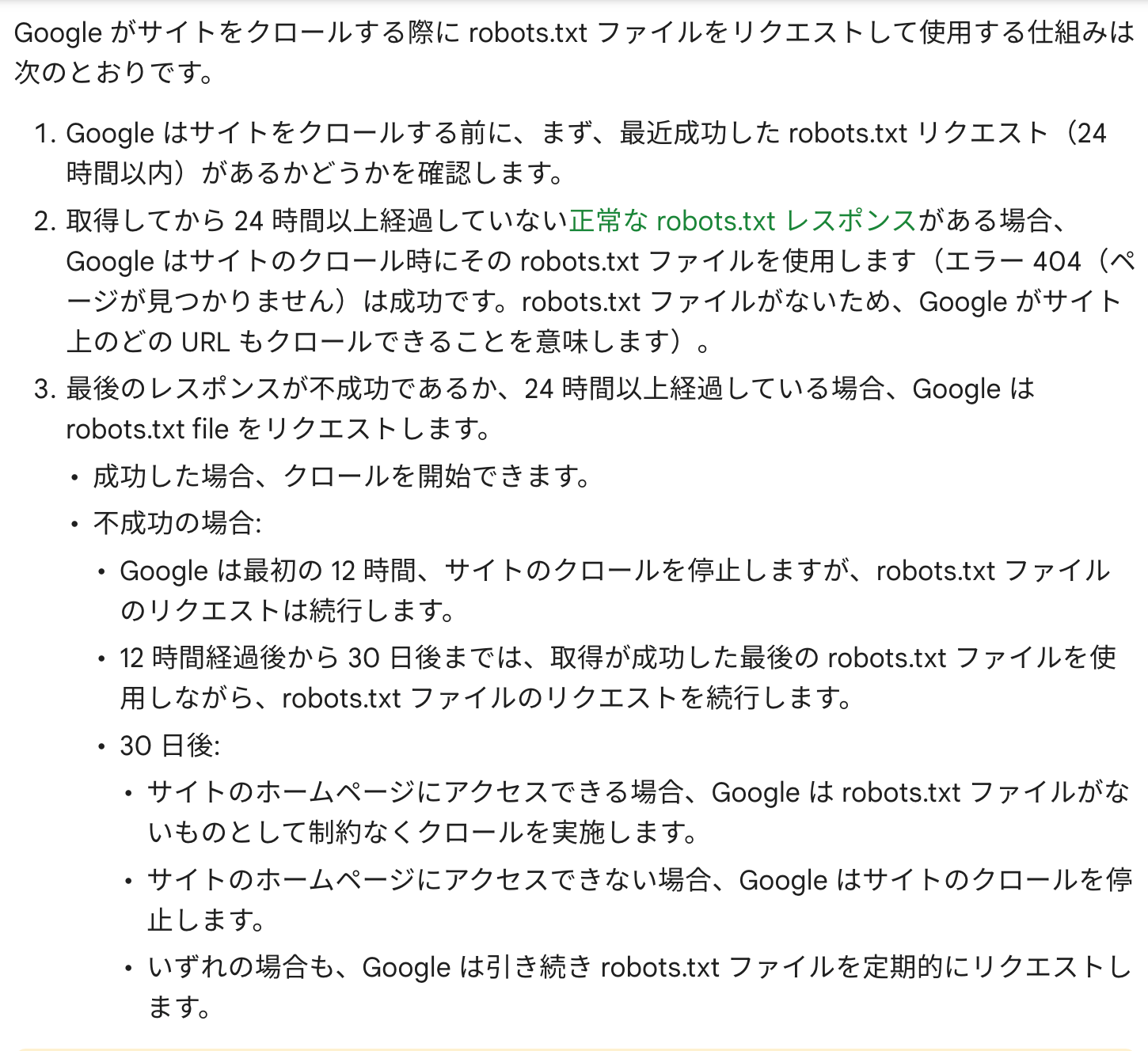

更新後は次のようになりました。

文字量が増えていることに気付くはずです。

特に注目したいのは、robots.txt をリクエストしたときの最後のレスポンスが不成功か、24 時間以上経過している場合の Googlebot の挙動です。

3. 最後のレスポンスが不成功であるか、24 時間以上経過している場合、Google は robots.txt file をリクエストします。

- 成功した場合、クロールを開始できます。

- 不成功の場合:

- Google は最初の 12 時間、サイトのクロールを停止しますが、robots.txt ファイルのリクエストは続行します。

- 12 時間経過後から 30 日後までは、取得が成功した最後の robots.txt ファイルを使用しながら、robots.txt ファイルのリクエストを続行します。

- 30 日後:

- サイトのホームページにアクセスできる場合、Google は robots.txt ファイルがないものとして制約なくクロールを実施します。

- サイトのホームページにアクセスできない場合、Google はサイトのクロールを停止します。

- いずれの場合も、Google は引き続き robots.txt ファイルを定期的にリクエストします。

robots.txt を取得できなかったときは、キャッシュしている robots.txt を利用し、取得できない状態が 30 日以上続くと robots.txt がないものとしてクロールするということは僕は認識していましたが、「最初の 12 時間、サイトのクロールを停止」するというのは初めて知りました。

「12 時間」という言及は今までに聞いたことがありません。

Googlebot が robots.txt にアクセスできない場合、短期間であればさほど問題ないことが多いのですが、長期にわたると検索に悪影響を及ぼすことがあります。

robots.txt に到達できないときに Googlebot がどのように対処するのかを、更新したヘルプ記事で再確認しておきましょう。

[H/T] Brodie Clark