[レベル: 上級]

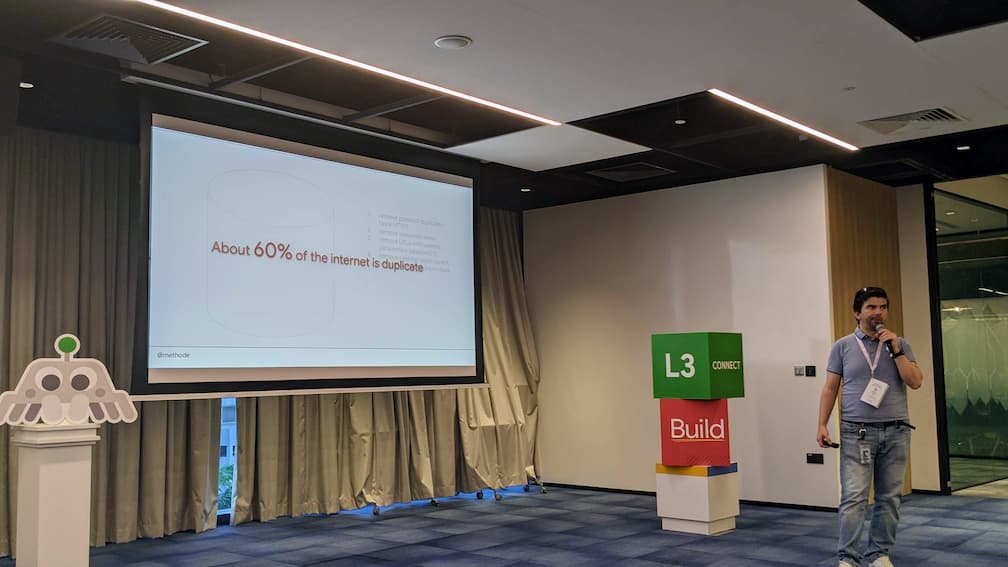

インターネットのおよそ 60% は重複である

11 月 24 日にシンガポールで開催された Search Central Live Conference Singapore のセッションに登壇した Gary Illyes(ゲイリー・イリェーシュ)氏はこんな数値に言及しました。

重複対象の URL

この数値が出てきたのは、クロールとインデックスの詳細をゲイリーが解説したセッションです。

ゲイリーは、次のプロセスにクロールを細かく分解しました。

- URL Extraction(URL 抽出)

- Normalizing(ノーマライズ)

- Dedupulication(重複解消)

3 番目の Dedupulication(重複解消)のプロセスの説明中に紹介されたのが「インターネットのおよそ 60% は重複である」というデータです。

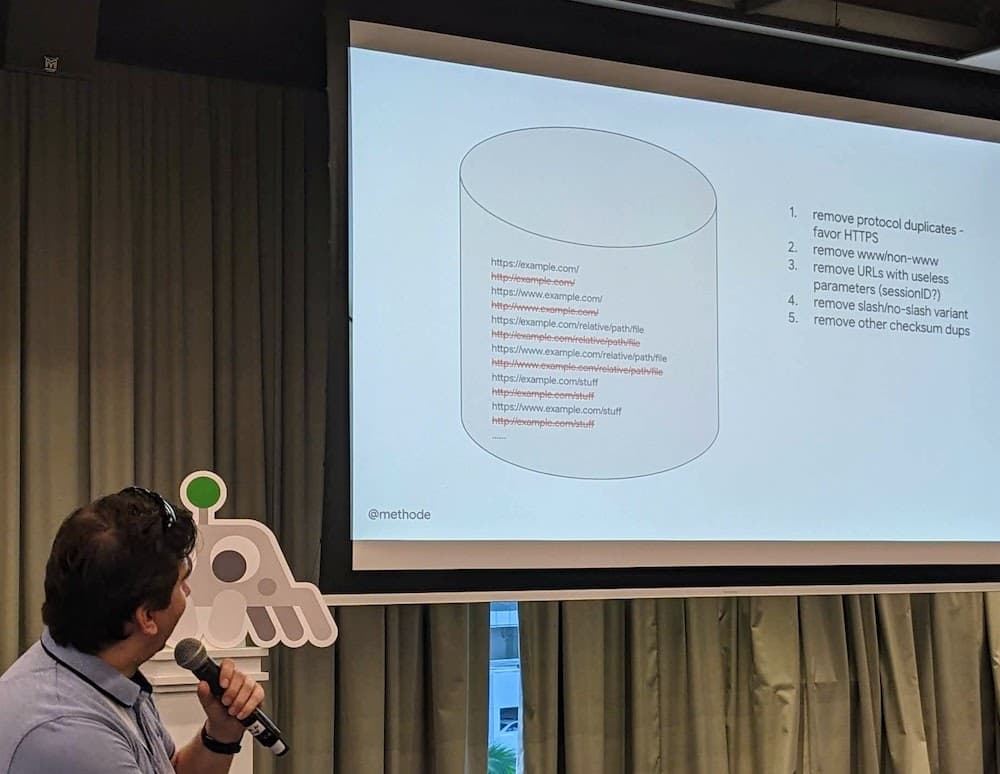

次のような状態の URL を Dedupulication のプロセスでは重複とみなし解消します。

- プロトコルの重複解消――

httpvs.https(httpsを優先)- www ありと www なしの重複解消

- 意味のないパラメータの重複解消――例: セッション ID

- 末尾に

/(スラッシュ)が付く URL と付かない URL の重複解消- チェックサムによる重複解消

5 つめのチェックサムとは、データの同一性を確認するための技術です。

URL が異なっていても、(メインコンテンツの)チェックサムが同じなら中身が同じコンテンツだという証拠になります。

こうした URL を統計的に処理すると 60% という数字が出てくるようです。

実に半分以上が重複ということになります。

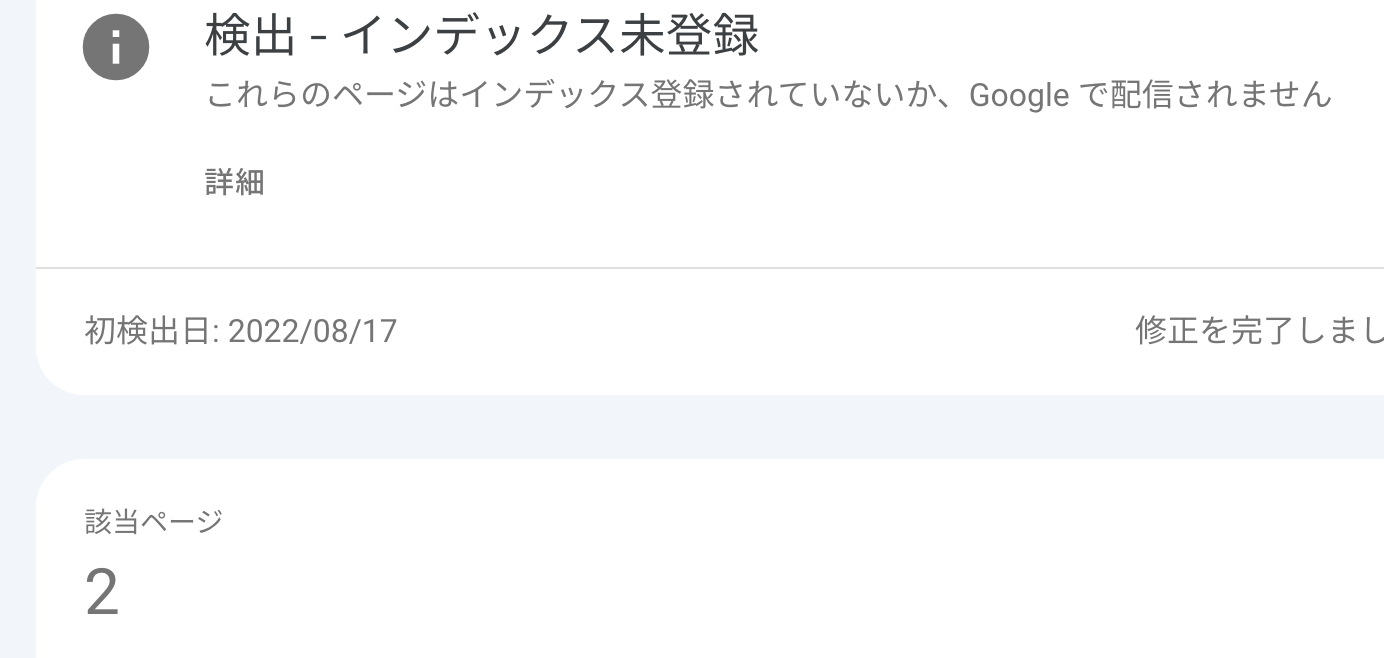

なお、重複と認識された URL は、発見してもクロールする必要がないと Google は判断することがあります。

そうした URL は、Search Console のページのインデックス登録レポートでは「検出 – インデックス未登録」として分類される場合もあります。

重複していることがわかっているなら、最初からクロールする必要はありませんね。

このセッションは、クロールとインデックスのプロセスを、般的に知られている内容よりも技術的にもっと深堀りしたものでした。

機会を見付けてこのブログで共有したいと思います。